Группа исследователей из Массачусетского технологического института и Нью-Йоркского университета разработала новую систему искусственного интеллекта, которая оказалась способной ввести в заблуждение людей-судей когда дело коснулось рисования символов, напоминающих буквы какого-то экзотического алфавита. Этот эксперимент, результаты которого были опубликованы в журнале Science, можно рассматривать как прохождение визуального варианта теста Тьюринга, предназначенного для определения степени совершенства систем искусственного интеллекта.

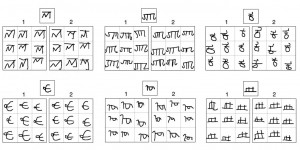

В ходе эксперимента человеку и компьютеру показали незнакомый им символ, который напоминает некую букву. На приведенном немного ниже изображении вы можете увидеть примеры таких символов. В первой части эксперимента человек и компьютер должны были внести изменения в символ таким образом, чтобы он немного исказился, но оставался после этого узнаваемым. В других частях теста человеку и компьютеру выдали целую серию символов и им требовалось создать новый символ, который вписывается в представленную серию.

После того, как человек и компьютер выполнили поставленные задачи, команда судей попыталась определить, какие из символов были нарисованы системой искусственного интеллекта. Через некоторое время, проведенное в разглядывании нарисованных «закорлючек», судьи вынесли свое решение, а точность определения ими работы искусственного интеллекта составила 50 процентов, другими словами, они не смогли однозначно отделить работу человека от работы компьютера.

Мы предоставляем нашим читателям самим побывать в роли судей. На третьем изображении приведены рисунки шести символов, разбитые на две группы, каждую из которых нарисовал или человек или компьютер. Попытайтесь определить это сами, а правильные ответы приведены в самом низу этой страницы.

Все это походит на весьма странный эксперимент, но у него имеется очень глубокое и далекоидущее значение. В обычных условиях системы искусственного интеллекта проходят предварительное обучение на больших наборах данных прежде, чем они самостоятельно смогут решать определенные задачи. Человек, в отличие от этого, способен учиться «на лету», выполняя работу сразу и постепенно совершенствуя свои навыки.

В новой системе искусственного интеллекта как раз и была реализована технология «обучения на лету» в основу которой легли самообучающиеся алгоритмы Bayesian Program Learning. Эти алгоритмы подходят к проблеме обучения точно таким же образом, которым люди изучают неизвестные им до этого понятия. «Сначала наша программа составляет весьма грубую модель данных, с которыми ей предстоит работать. После этого специальные алгоритмы заполняют пробелы в этой модели, анализируя результаты своей деятельности или примеры подобной деятельности, сделанной людьми или другими системами».

В данном случае программа определила, что процесс рисования символов состоит из так называемых «ударов», разделенных отрывом ручки от бумаги. Удары, в свою очередь, состоят из серии более мелких действий, разделенных точками, в которых скорость ручки равна нулю. Составив такую обобщенную модель, система искусственного интеллекта произвела анализ движений ручки при рисовании людьми символов из различных алфавитов, и этот анализ дал в ее «руки» возможность рисования новых и повторения уже нарисованных символов.

«Множество систем были созданы с целью распознавания символов» — рассказывает Джош Тененбаум (Josh Tenenbaum), один из исследователей,— «Такие системы терпят неудачу в идентификации символа, если его часть прорисована нечетко или не нарисована вообще, как это часто бывает в рукописном тексте. Наша система искусственного интеллекта свободна от этого недостатка, ведь она не занимается оценкой формы символа, а производит анализ порядка его начертания. Система определяет, из чего состоит каждый символ и ей не представляет труда идентифицировать его даже тогда, когда в рисунке отсутствуют целые части».

И в заключение приводим правильные ответы к третьему рисунку. Искусственный интеллект является «автором» 1, 2 и 1 наборов символов в первой строке, и 2, 1 и 1 наборов символов во второй строке.

Источник:gizmodo.com